AI Hacking là gì?

Tấn công AI là việc sử dụng trí tuệ nhân tạo để tăng cường hoặc tự động hóa các cuộc tấn công mạng. Nó cho phép kẻ tấn công tạo mã, phân tích hệ thống và vượt qua các biện pháp phòng thủ với nỗ lực thủ công tối thiểu.

Các mô hình AI, đặc biệt là các mô hình ngôn ngữ lớn (LLM), giúp việc phát triển tấn công nhanh hơn, rẻ hơn và dễ tiếp cận hơn với những hacker ít kinh nghiệm. Kết quả là một loạt các cuộc tấn công AI mới nhanh hơn, có khả năng mở rộng hơn và thường khó bị ngăn chặn hơn bằng các biện pháp phòng thủ truyền thống.

Hacker AI là gì?

Tin tặc AI là tác nhân đe dọa sử dụng trí tuệ nhân tạo để tự động hóa, tăng cường hoặc mở rộng quy mô các cuộc tấn công mạng. Tin tặc AI sử dụng các mô hình học máy, AI tổng hợp và các tác nhân tự động để vượt qua các biện pháp kiểm soát bảo mật, tạo ra các cuộc tấn công lừa đảo có độ tin cậy cao và khai thác lỗ hổng bảo mật phần mềm ở quy mô lớn.

Những kẻ tấn công này có thể bao gồm cả người vận hành sử dụng công cụ AI và các hệ thống bán tự động thực hiện các tác vụ với sự can thiệp tối thiểu của con người. Những kẻ tấn công sử dụng AI là những cá nhân ngoài đời thực—tội phạm, script kiddies, hacker, hoặc các tác nhân quốc gia—những người sử dụng mô hình AI để tăng cường khả năng tấn công của mình.

Các tác nhân hack tự động là quy trình làm việc do AI điều khiển, có thể kết nối các tác vụ—chẳng hạn như trinh sát, tạo tải trọng và né tránh—với sự giám sát tối thiểu. Mặc dù vẫn được hướng dẫn bởi các mục tiêu do con người xác định, các tác nhân này có thể hoạt động bán độc lập sau khi được khởi chạy, thực hiện các cuộc tấn công nhiều bước hiệu quả hơn so với các công cụ thủ công.

AI được sử dụng cho tội phạm mạng như thế nào?

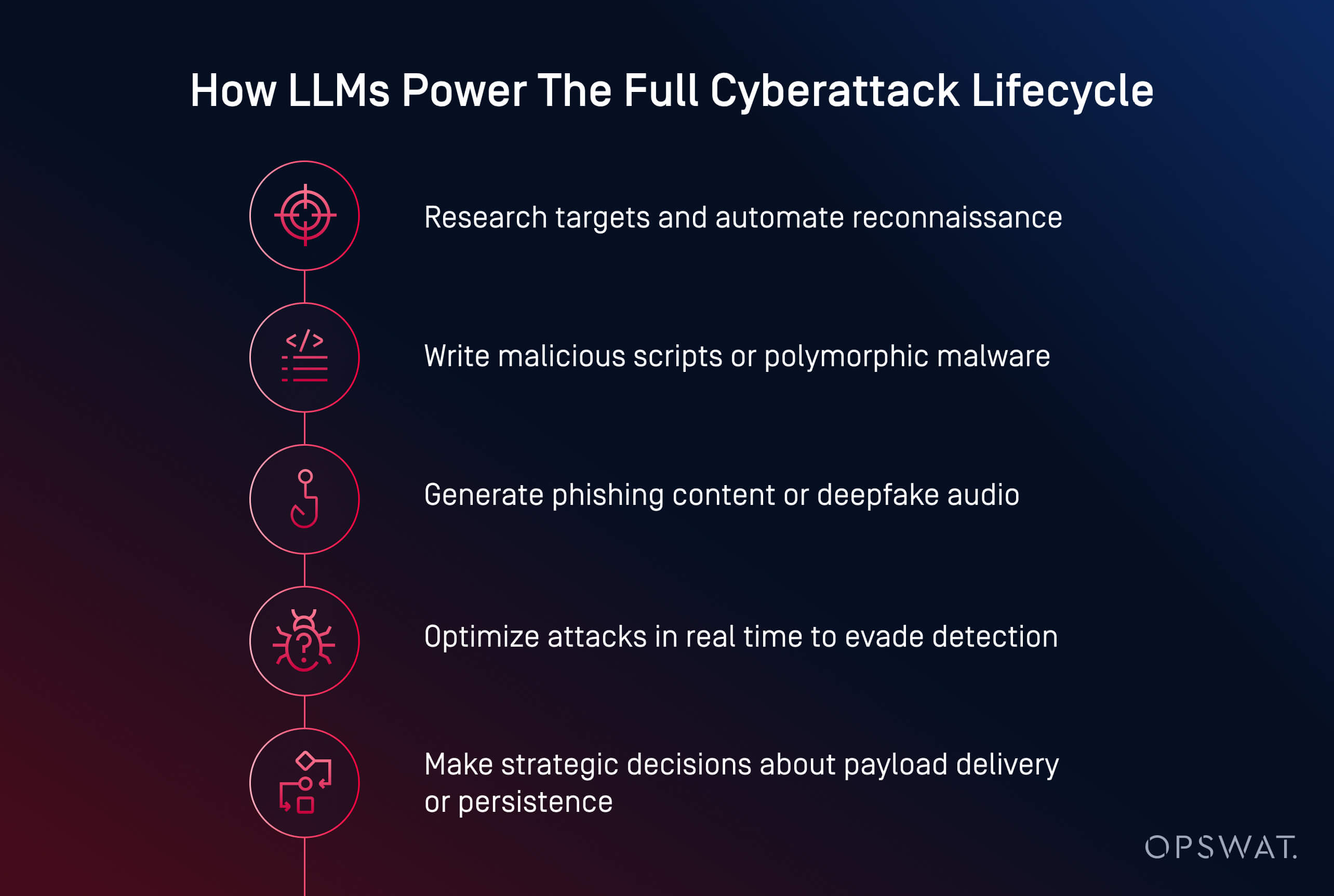

Các tác nhân đe dọa AI hiện đang sử dụng trí tuệ nhân tạo để triển khai các cuộc tấn công mạng nhanh hơn, thông minh hơn và thích ứng hơn. Từ việc tạo mã độc đến tự động hóa lừa đảo, AI đang biến tội phạm mạng thành một hoạt động có khả năng mở rộng. Giờ đây, nó có thể tạo mã độc, viết nội dung lừa đảo hấp dẫn và thậm chí dẫn dắt kẻ tấn công qua toàn bộ chuỗi tấn công.

Tội phạm mạng sử dụng AI trong một số lĩnh vực cốt lõi:

- Tạo tải trọng: Các công cụ như HackerGPT và WormGPT có thể viết mã độc được mã hóa , tự động hóa các chiến thuật né tránh và chuyển đổi tập lệnh thành tệp thực thi. Đây là những ví dụ về tấn công AI sinh sản, thường thấy trong các cuộc tấn công mạng nhắm vào tác nhân AI, trong đó các mô hình đưa ra quyết định tự động.

- Kỹ thuật xã hội: AI tạo ra email lừa đảo giống thật, sao chép giọng nói và tạo deepfake để thao túng nạn nhân hiệu quả hơn.

- Do thám và lập kế hoạch: AI giúp tăng tốc quá trình nghiên cứu mục tiêu, lập bản đồ cơ sở hạ tầng và xác định lỗ hổng bảo mật.

- Tự động hóa ở quy mô lớn: Kẻ tấn công sử dụng AI để triển khai các chiến dịch nhiều giai đoạn với sự can thiệp tối thiểu của con người.

Theo Viện Ponemon, AI đã được sử dụng trong các chiến dịch ransomware và tấn công lừa đảo gây ra sự gián đoạn hoạt động lớn, bao gồm cả hành vi đánh cắp thông tin đăng nhập và buộc phải đóng cửa hơn 300 địa điểm bán lẻ trong vụ vi phạm năm 2023.

Một số mô hình mới nổi đang định hình lại bối cảnh đe dọa:

- Dân chủ hóa các cuộc tấn công mạng: Các mô hình nguồn mở như LLaMA, được tinh chỉnh để tấn công, hiện có sẵn cho bất kỳ ai có sức mạnh tính toán cục bộ

- Rào cản gia nhập thấp hơn: Những gì trước đây đòi hỏi kỹ năng chuyên môn giờ đây có thể được thực hiện chỉ bằng lời nhắc đơn giản và vài cú nhấp chuột

- Tăng khả năng trốn tránh thành công: mã độc do AI tạo ra có khả năng ẩn mình tốt hơn khỏi các phát hiện tĩnh, môi trường giả lập và thậm chí cả phân tích động

- Mô hình mã độc dưới dạng dịch vụ (MaaS): Tội phạm mạng đang tích hợp các khả năng AI vào các bộ công cụ theo đăng ký, giúp dễ dàng triển khai các cuộc tấn công phức tạp trên quy mô lớn

- Sử dụng AI trong các vụ vi phạm thực tế: Viện Ponemon báo cáo rằng những kẻ tấn công đã sử dụng AI để tự động nhắm mục tiêu vào phần mềm tống tiền, bao gồm cả trong các sự cố buộc phải đóng cửa các hoạt động lớn

Lừa đảo và kỹ thuật xã hội được hỗ trợ bởi AI

Lừa đảo và kỹ thuật xã hội sử dụng AI đang biến các hình thức lừa đảo truyền thống thành các cuộc tấn công có khả năng mở rộng, được cá nhân hóa và khó phát hiện hơn. Kẻ tấn công hiện sử dụng các mô hình sinh sản để tạo ra các email đáng tin cậy, sao chép giọng nói và thậm chí tạo ra các cuộc gọi video giả mạo để thao túng mục tiêu.

Không giống như các hình thức lừa đảo truyền thống, email lừa đảo do AI tạo ra được trau chuốt và thuyết phục hơn. Các công cụ như ChatGPT và WormGPT tạo ra các thông điệp mô phỏng giao tiếp nội bộ, tiếp cận dịch vụ khách hàng hoặc cập nhật thông tin nhân sự. Khi được kết hợp với dữ liệu bị xâm phạm, những email này sẽ được cá nhân hóa và có nhiều khả năng thành công hơn.

AI cũng thúc đẩy các hình thức kỹ thuật xã hội mới hơn:

- Các cuộc tấn công sao chép giọng nói bắt chước các giám đốc điều hành sử dụng các mẫu âm thanh ngắn để kích hoạt các hành động khẩn cấp như chuyển khoản điện tử

- Các cuộc tấn công Deepfake mô phỏng các cuộc gọi video hoặc các cuộc họp từ xa để lừa đảo với số tiền lớn

Trong một vụ việc gần đây , kẻ tấn công đã sử dụng email do AI tạo ra trong thời gian đăng ký phúc lợi, giả danh bộ phận nhân sự để đánh cắp thông tin đăng nhập và truy cập hồ sơ nhân viên. Mối nguy hiểm nằm ở ảo tưởng về lòng tin. Khi một email trông có vẻ nội bộ, giọng nói nghe quen thuộc, và yêu cầu có vẻ cấp bách, ngay cả nhân viên được đào tạo bài bản cũng có thể bị lừa.

Phát hiện và khai thác lỗ hổng bảo mật AI

Trí tuệ nhân tạo (AI) đang đẩy nhanh cách thức kẻ tấn công tìm kiếm và khai thác lỗ hổng bảo mật phần mềm. Việc dò tìm thủ công trước đây mất nhiều ngày, giờ đây có thể được thực hiện chỉ trong vài phút nhờ các mô hình học máy được đào tạo để trinh sát và tạo lỗ hổng bảo mật.

Các tác nhân đe dọa sử dụng AI để tự động quét lỗ hổng bảo mật trên các hệ thống công cộng, xác định cấu hình yếu, phần mềm lỗi thời hoặc các lỗ hổng bảo mật CVE chưa được vá. Không giống như các công cụ truyền thống, AI có thể đánh giá bối cảnh tiếp xúc để giúp kẻ tấn công ưu tiên các mục tiêu có giá trị cao.

Các chiến thuật khai thác phổ biến được hỗ trợ bởi AI bao gồm:

- Tự động kiểm tra để phát hiện lỗ hổng bảo mật zero-day nhanh hơn

- Tạo tập lệnh tùy chỉnh để thực thi mã từ xa hoặc di chuyển ngang

- Bẻ khóa mật khẩu và tấn công bằng vũ lực được tối ưu hóa thông qua học mẫu và mô hình xác suất

- Các bot trinh sát quét mạng để tìm kiếm tài sản có rủi ro cao với độ nhiễu tối thiểu

Các mô hình tạo sinh như LLaMA, Mistral hoặc Gemma có thể được tinh chỉnh để tạo ra các tải trọng phù hợp, chẳng hạn như mã vỏ hoặc các cuộc tấn công tiêm mã, dựa trên các đặc điểm cụ thể của hệ thống, thường bỏ qua các biện pháp bảo vệ được tích hợp trong các mô hình thương mại.

Xu hướng rất rõ ràng: AI cho phép kẻ tấn công phát hiện và xử lý các lỗ hổng bảo mật bảo mật với tốc độ nhanh như máy tính. Theo Viện Ponemon , 54% chuyên gia an ninh mạng coi các lỗ hổng bảo mật chưa được vá là mối quan tâm hàng đầu của họ trong thời đại tấn công AI.

mã độc và phần mềm tống tiền do AI điều khiển

Sự gia tăng của mã độc do AI tạo ra đồng nghĩa với việc các biện pháp phòng thủ truyền thống không còn đủ hiệu quả. Kẻ tấn công giờ đây có những công cụ có thể suy nghĩ, thích nghi và né tránh - thường nhanh hơn khả năng phản ứng của hệ thống phòng thủ.

Phần mềm tống tiền và mã độc đa hình được hỗ trợ bởi AI đang định hình lại cách thức tấn công mạng phát triển. Thay vì viết các đoạn mã tĩnh, kẻ tấn công giờ đây sử dụng AI để tạo ra mã độc đa hình - mã liên tục thay đổi để tránh bị phát hiện.

Các mối đe dọa ransomware cũng đang phát triển. AI có thể giúp lựa chọn tệp nào cần mã hóa, phân tích giá trị hệ thống và xác định thời điểm tối ưu để kích nổ. Các mô hình này cũng có thể tự động hóa hàng Thiết lập rào cản địa lý, tránh sandbox và thực thi trong bộ nhớ - những kỹ thuật thường được các tác nhân đe dọa tiên tiến sử dụng.

Việc trích xuất dữ liệu bằng AI sẽ tự động thích ứng để tránh bị phát hiện. Các thuật toán có thể nén, mã hóa và trích xuất dữ liệu một cách bí mật bằng cách phân tích các mẫu lưu lượng, tránh các yếu tố kích hoạt phát hiện. Một số tác nhân mã độc đang bắt đầu đưa ra các quyết định chiến lược: lựa chọn thời điểm, địa điểm và cách thức trích xuất dựa trên những gì chúng quan sát được bên trong môi trường bị xâm phạm.

Ví dụ về các cuộc tấn công mạng AI

Các cuộc tấn công mạng bằng AI không còn là lý thuyết nữa; chúng đã được sử dụng để đánh cắp dữ liệu, vượt qua hàng phòng thủ và mạo danh con người ở quy mô lớn.

Các ví dụ trong ba danh mục đáng chú ý dưới đây cho thấy kẻ tấn công không còn cần kỹ năng chuyên sâu để gây ra thiệt hại nghiêm trọng trong các cuộc tấn công mạng. AI giúp giảm rào cản xâm nhập, đồng thời tăng tốc độ tấn công, quy mô và khả năng ẩn náu. Các bên phòng thủ phải thích ứng bằng cách chủ động kiểm tra các hệ thống tích hợp AI và triển khai các biện pháp bảo vệ có tính đến cả thao túng kỹ thuật và lừa đảo con người.

1. Tấn công tiêm mã độc nhanh là gì?

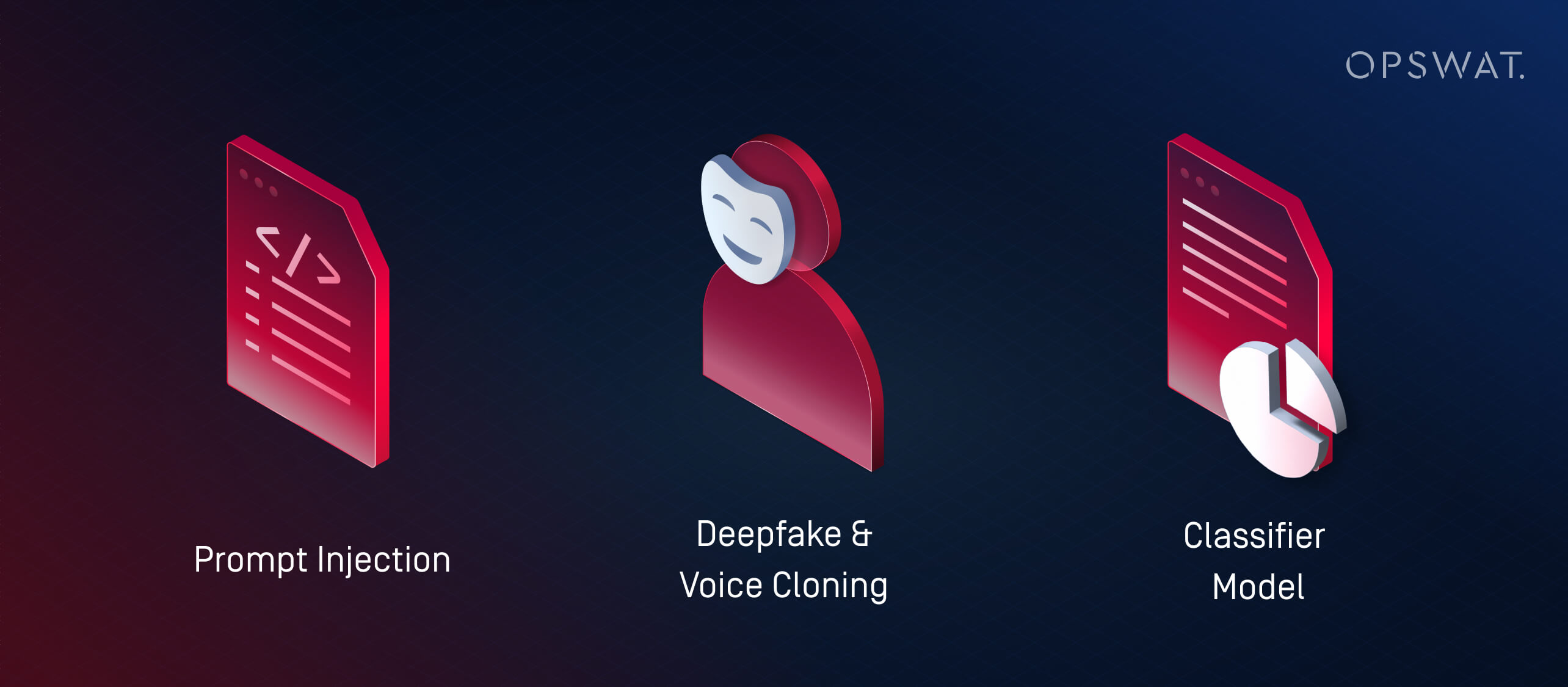

Tiêm mã nhanh là một kỹ thuật mà kẻ tấn công khai thác lỗ hổng bảo mật trong LLM (mô hình ngôn ngữ lớn) bằng cách cung cấp cho chúng các đầu vào được thiết kế đặc biệt để ghi đè hành vi dự định. Các cuộc tấn công này khai thác cách LLM diễn giải và ưu tiên các lệnh, thường ít hoặc không liên quan đến mã độc truyền thống.

Thay vì sử dụng AI để phát động các cuộc tấn công bên ngoài, việc tiêm mã nhanh chóng sẽ biến hệ thống AI của chính tổ chức thành tác nhân xâm phạm vô tình. Nếu một LLM được nhúng vào các công cụ như bộ phận hỗ trợ, chatbot hoặc trình xử lý tài liệu mà không có biện pháp bảo vệ thích hợp, kẻ tấn công có thể nhúng các lệnh ẩn mà mô hình sau đó diễn giải và hành động theo. Điều này có thể dẫn đến:

- Rò rỉ dữ liệu riêng tư hoặc bị hạn chế

- Thực hiện các hành động không mong muốn (ví dụ: gửi email, thay đổi hồ sơ)

- Thao túng đầu ra để phát tán thông tin sai lệch hoặc kích hoạt các hành động tiếp theo

Những rủi ro này gia tăng trong các hệ thống mà nhiều mô hình trao đổi thông tin với nhau. Ví dụ, một lời nhắc độc hại được nhúng trong tài liệu có thể ảnh hưởng đến trình tóm tắt AI, sau đó chuyển những thông tin sai lệch đến các hệ thống hạ nguồn.

Khi AI ngày càng được tích hợp sâu hơn vào quy trình làm việc kinh doanh, kẻ tấn công ngày càng nhắm mục tiêu vào các mô hình này để làm tổn hại lòng tin, trích xuất dữ liệu hoặc thao túng các quyết định từ bên trong.

2. Tấn công Deepfake và sao chép giọng nói là gì?

Các cuộc tấn công deepfake sử dụng âm thanh hoặc video do AI tạo ra để mạo danh người dùng theo thời gian thực. Kết hợp với các chiến thuật tấn công mạng, những công cụ này đang được sử dụng để lừa đảo, đánh cắp thông tin đăng nhập và truy cập hệ thống trái phép.

Việc sao chép giọng nói đã trở nên đặc biệt nguy hiểm. Chỉ với vài giây ghi âm, kẻ tấn công có thể tạo ra âm thanh bắt chước giọng điệu, nhịp độ và ngữ điệu. Những giọng nói được sao chép này sau đó được sử dụng để:

- Đóng giả giám đốc điều hành hoặc quản lý trong các cuộc gọi khẩn cấp

- Lừa nhân viên chuyển khoản hoặc đặt lại mật khẩu

- Bỏ qua hệ thống xác thực giọng nói

Deepfake còn tiến xa hơn một bước bằng cách tạo ra các video giả mạo. Kẻ tấn công có thể giả mạo CEO trong một cuộc gọi video yêu cầu dữ liệu mật—hoặc xuất hiện trong các đoạn clip ghi hình "thông báo" những thay đổi chính sách nhằm lan truyền thông tin sai lệch. Viện Ponemon đã báo cáo một sự cố trong đó kẻ tấn công sử dụng tin nhắn do AI tạo ra để mạo danh bộ phận nhân sự trong thời gian đăng ký phúc lợi của một doanh nghiệp, dẫn đến việc đánh cắp thông tin đăng nhập.

Khi các công cụ AI trở nên dễ tiếp cận hơn, ngay cả những kẻ tấn công nhỏ lẻ cũng có thể tạo ra các cuộc tấn công giả mạo với độ chân thực cao. Những cuộc tấn công này vượt qua các bộ lọc thư rác truyền thống hoặc hệ thống phòng thủ thiết bị đầu cuối bằng cách lợi dụng lòng tin.

3. Tấn công mô hình phân loại (học máy đối kháng) là gì?

Các cuộc tấn công mô hình phân loại thao túng dữ liệu đầu vào hoặc hành vi của hệ thống AI để đưa ra quyết định sai lầm mà không nhất thiết phải viết mã độc hoặc khai thác mã. Những chiến thuật này thuộc phạm trù rộng hơn của học máy đối kháng.

Có hai chiến lược chính:

- Tấn công né tránh: Kẻ tấn công tạo ra một đầu vào đánh lừa bộ phân loại để xác định sai, chẳng hạn như mã độc bắt chước các tệp vô hại để vượt qua các công cụ chống vi rút

- Tấn công đầu độc: Một mô hình được đào tạo hoặc tinh chỉnh trên dữ liệu bị bóp méo một cách có chủ đích, làm thay đổi khả năng phát hiện các mối đe dọa của nó

Các mô hình được giám sát thường "quá khớp": chúng học các mẫu cụ thể từ dữ liệu huấn luyện và bỏ lỡ các cuộc tấn công chỉ lệch một chút. Kẻ tấn công lợi dụng điều này bằng cách sử dụng các công cụ như WormGPT (một LLM mã nguồn mở được tinh chỉnh cho các tác vụ tấn công) để tạo ra các tải trọng nằm ngoài ranh giới phát hiện đã biết.

Đây là phiên bản máy học của lỗ hổng bảo mật zero-day.

Tin tặc AI so với tin tặc truyền thống: Những điểm khác biệt chính

Tin tặc AI sử dụng AI để tự động hóa, nâng cao và mở rộng quy mô các cuộc tấn công mạng AI. Ngược lại, tấn công truyền thống thường đòi hỏi việc viết mã thủ công, chuyên môn kỹ thuật sâu rộng và đầu tư thời gian đáng kể. Sự khác biệt cơ bản nằm ở tốc độ, khả năng mở rộng và khả năng tiếp cận: ngay cả những kẻ tấn công mới vào nghề giờ đây cũng có thể thực hiện các cuộc tấn công mạng tinh vi được hỗ trợ bởi AI chỉ với một vài lệnh nhắc và một GPU cấp độ người dùng thông thường.

Diện mạo | Tin tặc AI | Hacking truyền thống |

|---|---|---|

Tốc độ | Gần như ngay lập tức với tự động hóa | Viết kịch bản thủ công chậm hơn |

Yêu cầu về kỹ năng | Dựa trên lời nhắc; rào cản gia nhập thấp, nhưng yêu cầu quyền truy cập và điều chỉnh mô hình | Cao; đòi hỏi chuyên môn kỹ thuật sâu |

Khả năng mở rộng | Cao — hỗ trợ các cuộc tấn công nhiều giai đoạn trên nhiều mục tiêu | Bị giới hạn bởi thời gian và nỗ lực của con người |

Khả năng thích ứng | Năng động — AI điều chỉnh tải trọng và né tránh theo thời gian thực | Các tập lệnh tĩnh hoặc bán thích ứng |

Vector tấn công | LLM, deepfake, tấn công mô hình phân loại, tác nhân tự động | mã độc, lừa đảo, trinh sát thủ công và khai thác |

Những lưu ý | Có thể không thể đoán trước; thiếu ý định và bối cảnh nếu không có sự giám sát của con người | Kiểm soát chiến lược hơn, nhưng chậm hơn và thủ công |

Lạm dụng AI và Học máy đối nghịch

Không phải tất cả các mối đe dọa AI đều liên quan đến việc tạo ra mã độc—một số nhắm vào chính hệ thống AI. Các chiến thuật học máy đối kháng như tiêm mã độc tức thời và đầu độc mô hình có thể thao túng bộ phân loại, bỏ qua khâu phát hiện hoặc làm sai lệch quyết định. Khi AI trở thành trọng tâm của quy trình bảo mật, những cuộc tấn công này làm nổi bật nhu cầu cấp thiết về việc kiểm tra nghiêm ngặt và giám sát của con người.

AI có thể bị lạm dụng để phát triển mã độc như thế nào: OPSWAT Phân tích chuyên gia

Những việc trước đây đòi hỏi kỹ năng nâng cao giờ chỉ cần nhắc nhở và vài cú nhấp chuột.

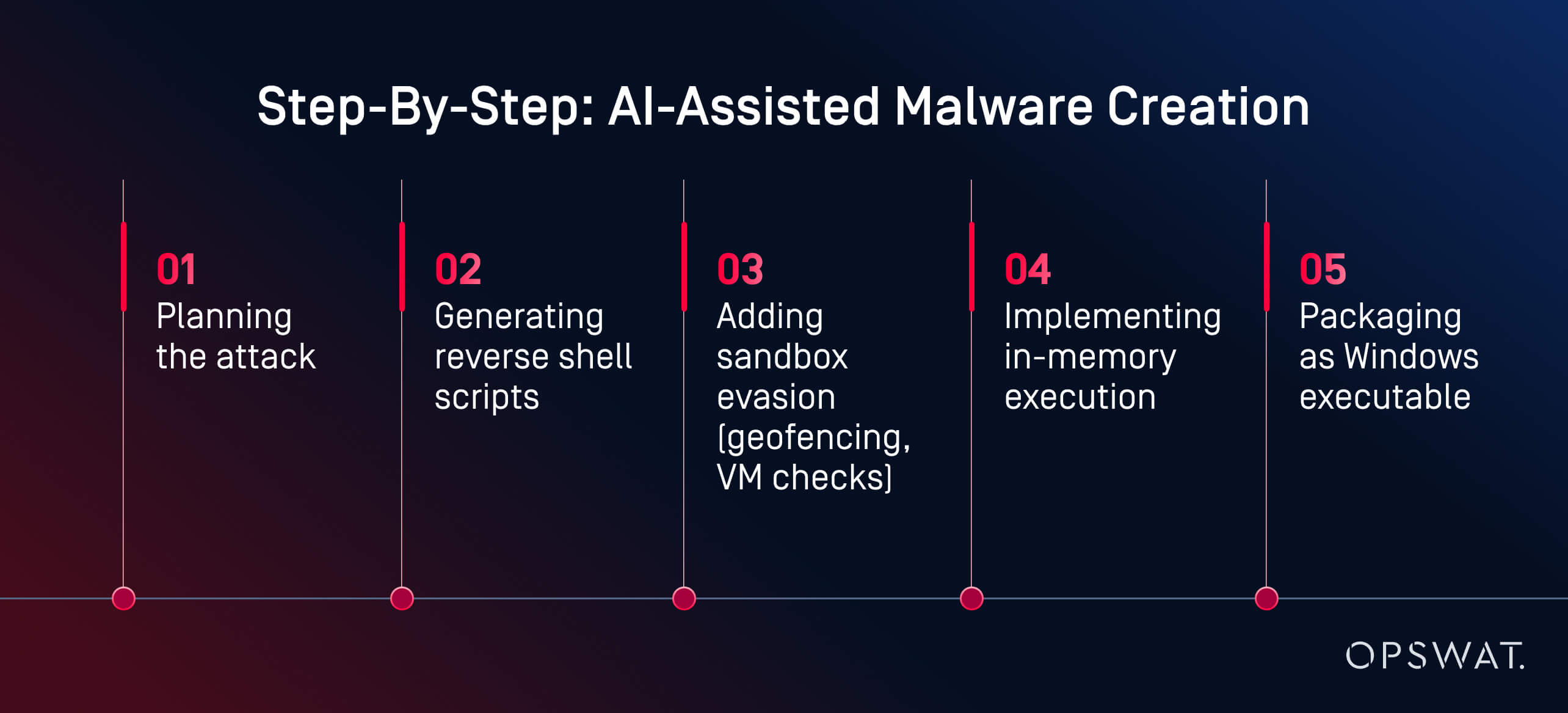

Trong một thí nghiệm trực tiếp, chuyên gia an ninh mạng Martin Kallas OPSWAT đã chứng minh cách sử dụng các công cụ AI để tạo ra mã độc ẩn nấp một cách nhanh chóng, tiết kiệm chi phí và không cần kỹ năng chuyên sâu. Sử dụng HackerGPT, Martin đã xây dựng một chuỗi mã độc hoàn chỉnh trong vòng chưa đầy hai giờ. Mô hình đã hướng dẫn anh qua từng giai đoạn:

“AI đã hướng dẫn tôi qua từng giai đoạn: lập kế hoạch, che giấu, né tránh và thực thi”, Martin giải thích. Kết quả là “... một payload do AI tạo ra đã thoát khỏi sự phát hiện của 60/63 công cụ diệt virus trên VirusTotal.” Phân tích hành vi và môi trường giả lập cũng không thể xác định nó là độc hại.

Đây không phải là một quốc gia. Đây không phải là một hacker mũ đen. Đó là một nhà phân tích có động cơ sử dụng các công cụ công khai trên GPU dành cho người tiêu dùng. Yếu tố then chốt? Các mô hình AI được lưu trữ cục bộ, không bị hạn chế. Với hơn một triệu mô hình mã nguồn mở có sẵn trên các nền tảng như Hugging Face, kẻ tấn công có thể lựa chọn từ một thư viện khổng lồ, tinh chỉnh chúng cho các mục đích xấu và chạy chúng mà không bị giám sát. Không giống như các dịch vụ đám mây, các LLM cục bộ có thể được lập trình lại để bỏ qua các biện pháp bảo vệ và thực hiện các tác vụ tấn công.

"Đây chính là những gì một người nghiệp dư đầy nhiệt huyết có thể làm được. Hãy tưởng tượng một quốc gia có thể làm được những gì", Martin cảnh báo. Ví dụ của ông cho thấy việc lạm dụng AI có thể biến tội phạm mạng từ một nghề nghiệp lành nghề thành một quy trình làm việc dễ tiếp cận, được hỗ trợ bởi AI. Ngày nay, việc tạo ra mã độc không còn là một nút thắt cổ chai nữa. Việc phát hiện phải phát triển nhanh hơn những công cụ mà kẻ tấn công hiện có trong tầm tay.

Cách phòng thủ chống lại các cuộc tấn công mạng sử dụng AI

Chúng ta cần hệ thống phòng thủ nhiều lớp chứ không chỉ là khả năng phát hiện thông minh hơn.

Việc bảo vệ hệ thống khỏi các cuộc tấn công mạng sử dụng AI đòi hỏi một chiến lược đa lớp, kết hợp tự động hóa với hiểu biết của con người, và phòng ngừa với phát hiện. Các giải pháp an ninh mạng hàng đầu sử dụng AI như OPSWAT Nền tảng phòng ngừa mối đe dọa tiên tiến tích hợp chức năng phòng ngừa và phát hiện. Xem video để tìm hiểu thêm.

Kiểm tra bảo mật AI và Red Teaming

Nhiều tổ chức đang chuyển sang sử dụng công nghệ nhóm đỏ được hỗ trợ bởi AI để kiểm tra khả năng phòng thủ của họ trước việc lạm dụng LLM, chèn mã độc nhanh và né tránh bộ phân loại. Những mô phỏng này giúp phát hiện các lỗ hổng bảo mật trong các hệ thống tích hợp AI trước khi kẻ tấn công kịp phát hiện.

Các đội đỏ sử dụng lời nhắc đối kháng, lừa đảo tổng hợp và các tải trọng do AI tạo ra để đánh giá xem hệ thống có khả năng phục hồi hoặc dễ bị khai thác hay không. Kiểm tra bảo mật AI cũng bao gồm:

- Mô hình làm mờ cho rủi ro tiêm nhanh

- Đánh giá cách LLM xử lý các đầu vào bị thao túng hoặc bị xâu chuỗi

- Kiểm tra độ mạnh của bộ phân loại đối với hành vi trốn tránh

Các nhà lãnh đạo an ninh cũng bắt đầu quét LLM của riêng họ để phát hiện rò rỉ tức thời, ảo giác hoặc truy cập ngoài ý muốn vào logic nội bộ. Đây là một bước trọng yếu khi AI tạo sinh được nhúng vào các sản phẩm và quy trình làm việc.

Một hệ thống phòng thủ thông minh hơn: OPSWAT Cách tiếp cận của

Thay vì cố gắng "chống lại AI bằng AI" trong một vòng lặp phản ứng, Martin Kallas lập luận cho một biện pháp phòng thủ chủ động, nhiều lớp. OPSWAT các giải pháp kết hợp các công nghệ nhắm mục tiêu vào toàn bộ vòng đời mối đe dọa:

- Metascan™ Multiscanning: Chạy các tệp qua nhiều công cụ diệt vi rút để phát hiện các mối đe dọa mà hệ thống công cụ diệt vi rút đơn lẻ bỏ sót

- MetaDefender Sandbox™: Phân tích hành vi tệp trong môi trường bị cô lập, thậm chí phát hiện các tải trọng do AI tạo ra tránh các quy tắc tĩnh

- Deep CDR™: Vô hiệu hóa các mối đe dọa bằng cách xây dựng lại các tệp thành phiên bản an toàn, loại bỏ các lỗ hổng bảo mật được nhúng

Ngăn xếp bảo mật nhiều lớp này được thiết kế để chống lại bản chất khó lường của mã độc do AI tạo ra, bao gồm các mối đe dọa đa hình, tải trọng trong bộ nhớ và các mồi nhử deepfake vượt qua các công cụ truyền thống. Vì mỗi lớp nhắm vào một giai đoạn khác nhau của chuỗi tấn công, nên chỉ cần một lớp là có thể phát hiện hoặc vô hiệu hóa mối đe dọa và làm sụp đổ toàn bộ hoạt động trước khi nó kịp gây ra thiệt hại.

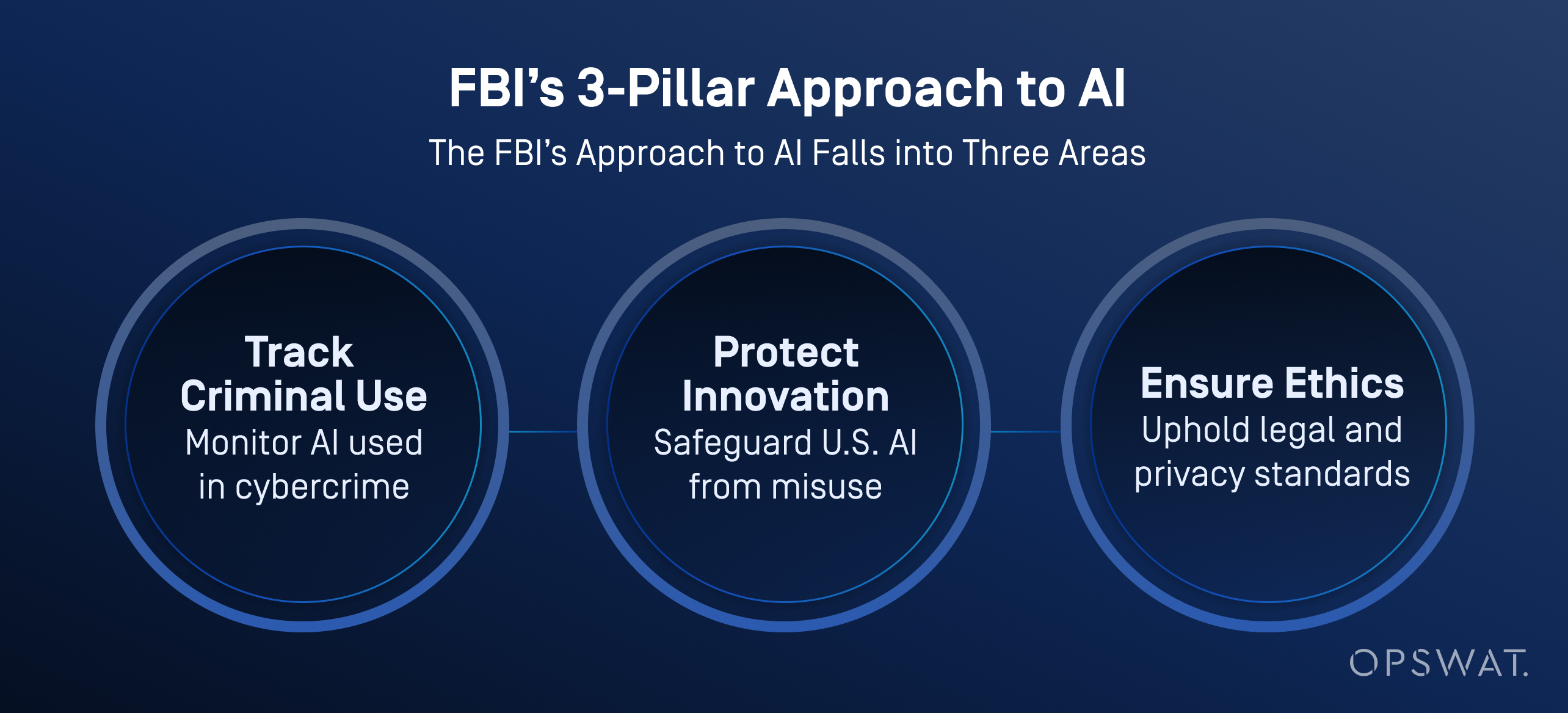

Các trường hợp sử dụng trong ngành: FBI sử dụng AI nào?

FBI và các cơ quan khác của Hoa Kỳ đang ngày càng tích hợp trí tuệ nhân tạo vào hoạt động phòng thủ mạng của họ không chỉ để phân loại và ưu tiên các mối đe dọa mà còn để tăng cường phân tích dữ liệu, phân tích video và nhận dạng giọng nói.

Theo FBI , AI giúp xử lý khối lượng lớn dữ liệu để tạo ra manh mối điều tra, bao gồm nhận dạng phương tiện, nhận dạng ngôn ngữ và chuyển đổi giọng nói thành văn bản. Quan trọng là, FBI thực thi giám sát chặt chẽ của con người: tất cả dữ liệu đầu ra do AI tạo ra phải được xác minh bởi các điều tra viên được đào tạo trước khi thực hiện bất kỳ hành động nào.

AI không phải là sự thay thế cho việc ra quyết định của con người. FBI nhấn mạnh rằng con người luôn phải chịu trách nhiệm về kết quả điều tra, và AI phải được sử dụng theo cách tôn trọng quyền riêng tư, quyền tự do dân sự và các tiêu chuẩn pháp lý.

Các tổ chức đã sẵn sàng chưa?

Bất chấp sự gia tăng của các mối đe dọa do AI gây ra, chỉ 37% chuyên gia bảo mật cho biết họ cảm thấy sẵn sàng ngăn chặn một cuộc tấn công mạng do AI gây ra, theo Báo cáo Tình hình An ninh mạng AI của Ponemon. Nhiều người vẫn dựa vào các kế hoạch quản lý rủi ro mạng lỗi thời và các chiến lược phát hiện phản ứng.

Con đường phía trước cần có 4 bước thiết yếu:

- Áp dụng nhanh hơn các công cụ phòng thủ nhận biết AI

- Nhóm đỏ liên tục và kiểm tra rủi ro kịp thời

- Sử dụng tích cực Multiscanning , CDR và môi trường giả lập

- Đào tạo các nhà phân tích SOC để làm việc cùng với các công cụ điều tra tự động

AI đã thay đổi các quy tắc. Mục tiêu không phải là thay thế con người mà là cung cấp cho họ công cụ để vượt qua các cuộc tấn công hiện đã có khả năng tự suy nghĩ. Khám phá cách nền tảng của chúng tôi giúp bảo mật tệp, thiết bị và luồng dữ liệu trên khắp môi trường IT và OT.

Câu hỏi thường gặp (FAQ)

Tin tặc AI là gì?

Tấn công AI là việc sử dụng các công cụ như mô hình ngôn ngữ lớn (LLM) để tự động hóa hoặc tăng cường các cuộc tấn công mạng. Nó giúp kẻ tấn công tạo mã độc, triển khai các chiến dịch lừa đảo và vượt qua hệ thống phòng thủ nhanh hơn và dễ dàng hơn trước.

AI được sử dụng cho tội phạm mạng như thế nào?

Tội phạm sử dụng AI để tạo mã độc, tự động hóa lừa đảo và tăng tốc độ quét lỗ hổng bảo mật. Một số công cụ như được bán trên các diễn đàn dark web thậm chí có thể dẫn dắt kẻ tấn công qua toàn bộ chuỗi tấn công.

Sự khác biệt giữa hack AI và hack truyền thống là gì?

Phương pháp hack truyền thống đòi hỏi kỹ năng lập trình, sử dụng công cụ và kỹ năng chuyên môn. Hack AI giúp giảm thiểu rào cản này bằng các mô hình tạo ra payload, script và nội dung lừa đảo từ những lời nhắc đơn giản. Các kỹ thuật này giúp các cuộc tấn công nhanh hơn, có khả năng mở rộng hơn và dễ tiếp cận hơn với người dùng nghiệp dư.

AI có thể bị lạm dụng để phát triển mã độc như thế nào?

AI có thể tạo ra mã độc đa hình, shell đảo ngược và tải trọng tránh môi trường giả lập với ít đầu vào. Như được hiển thị trong một OPSWAT demo, một người dùng không có ý đồ xấu đã tạo ra mã độc gần như zero-day trong vòng chưa đầy hai giờ bằng cách sử dụng các mô hình AI nguồn mở chạy trên PC chơi game.

AI có thể thay thế tin tặc không?

Chưa, nhưng nó có thể xử lý nhiều tác vụ kỹ thuật. Tin tặc vẫn chọn mục tiêu và mục đích, trong khi AI viết mã, tránh bị phát hiện và thích ứng với các cuộc tấn công. Rủi ro thực sự là những kẻ tấn công con người được khuếch đại bởi tốc độ của AI.

Hacker AI là gì?

Tin tặc AI là một người hoặc một hệ thống bán tự động sử dụng AI để phát động các cuộc tấn công mạng, tự động hóa mã độc hoặc thực hiện các chiến dịch lừa đảo trên quy mô lớn.

FBI sử dụng AI nào?

FBI sử dụng AI để phân loại mối đe dọa, phân tích pháp y, phát hiện bất thường và xử lý bằng chứng kỹ thuật số. Những công cụ này giúp tự động hóa các cuộc điều tra và phát hiện các vụ án ưu tiên cao, đồng thời giảm khối lượng công việc của các nhà phân tích.

Một ví dụ về tấn công AI là gì?

Một trường hợp thực tế liên quan đến email lừa đảo do AI tạo ra trong thời gian đăng ký phúc lợi của một doanh nghiệp. Kẻ tấn công đã mạo danh bộ phận nhân sự để đánh cắp thông tin đăng nhập. Trong một trường hợp khác, AI đã giúp tự động hóa việc nhắm mục tiêu ransomware, buộc một thương hiệu đa quốc gia phải ngừng hoạt động.

Tấn công mạng AI là gì?

Tấn công mạng AI là các mối đe dọa được phát triển hoặc thực hiện với sự trợ giúp của trí tuệ nhân tạo. Ví dụ bao gồm lừa đảo do AI tạo ra, giả mạo deepfake, chèn mã độc nhanh chóng và né tránh bộ phân loại. Những cuộc tấn công này thường vượt qua các biện pháp phòng thủ truyền thống.

Tin tặc và kẻ lừa đảo sử dụng AI để nhắm mục tiêu vào con người như thế nào?

Tin tặc sử dụng AI để cá nhân hóa email lừa đảo, sao chép giọng nói để lừa đảo qua điện thoại và tạo video deepfake để đánh lừa mục tiêu. Những chiến thuật này lợi dụng lòng tin của con người và khiến ngay cả những người dùng được đào tạo bài bản cũng dễ bị lừa bởi những trò lừa đảo thực tế do AI tạo ra.

Làm thế nào tôi có thể phòng thủ trước các cuộc tấn công do AI hỗ trợ?

Sử dụng biện pháp phòng thủ nhiều lớp: Multiscanning , sandbox, CDR và chiến thuật nhóm đỏ do con người chỉ huy. Các cuộc tấn công AI diễn ra nhanh chóng. Bên phòng thủ cần tự động hóa, bối cảnh và tốc độ để theo kịp.